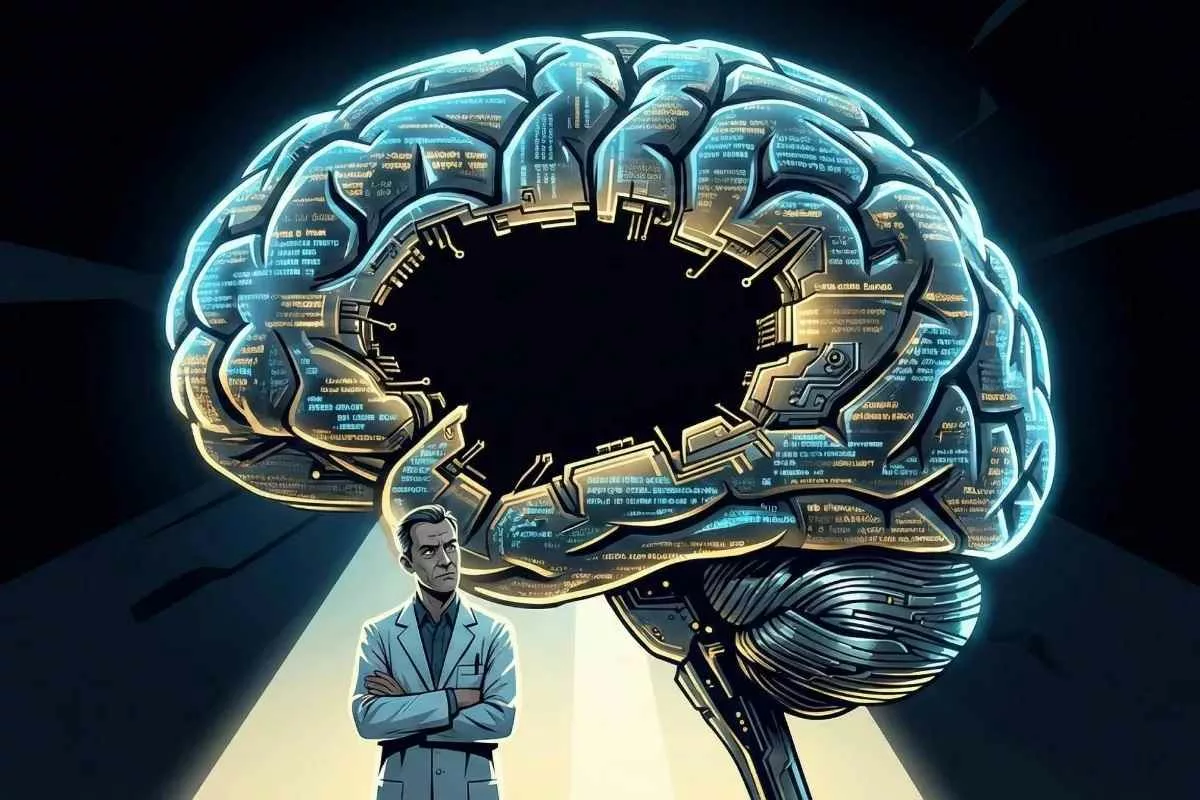

رویای ماشینهای متفکر فرو ریخت؛ مدلهای زبانی هرگز به هوش واقعی نمیرسند

رؤیای ماشینهای متفکر؛ واقعیت یا خیال؟

زبان و تفکر؛ دو مسیر جدا در ذهن انسان

از زمان ظهور اولین کامپیوترها، رویای ساختن موجودی ماشینی که بتواند مانند انسان فکر کند، استدلال کند، جهان را درک کند و خلاقیت از خود نشان دهد، همواره موتور محرک تحقیقات در حوزه هوش مصنوعی بوده است. در دهه اخیر، با ظهور مدلهای زبانی بزرگ (LLMs) نظیر GPT-4، LaMDA و مدلهای مشابه، این رؤیا به شکلی ظاهراً ملموستر از همیشه به نظر میرسد. این مدلها در تولید متن، کدنویسی، ترجمه و پاسخگویی به پرسشها به سطوحی خیرهکننده رسیدهاند که بسیاری را به این باور رسانده است که ما به آستانه هوش مصنوعی عمومی (AGI) رسیدهایم. با این حال، تحلیلهای عمیقتر علمی و شناختی نشان میدهند که آنچه این مدلها انجام میدهند، تقلیدی بسیار پیچیده از زبان است و نه تجلی تفکر حقیقی.

برای درک چرایی این محدودیت بنیادین، باید نخست به تمایز عمیق میان «زبان» و «تفکر» بپردازیم؛ تمایزی که در قلب علوم شناختی، عصبشناسی و فلسفه ذهن قرار دارد.

شواهد علوم شناختی برای استقلال تفکر از زبان

زبان ابزاری قدرتمند برای برقراری ارتباط، ذخیرهسازی دانش و سازماندهی مفاهیم است. با این حال، زبان تنها یکی از جنبههای شناخت است. تفکر، فرآیند ذهنی انتزاعیتری است که شامل استدلال، برنامهریزی، مدلسازی جهان، درک علیت، یادگیری از تجربه و آگاهی است.

در طول تاریخ، رابطه زبان و تفکر محل مناقشه بوده است. برخی نظریهها، مانند نظریه معروف «فرضیه ساپیر-وورف» (Sapir-Whorf Hypothesis) در شکل قوی خود، بر این باورند که ساختار زبان ما مستقیماً بر نحوه تفکر ما حاکم است. اما شواهد تجربی، به ویژه در حوزه علوم شناختی، به شدت از دیدگاهی پشتیبانی میکنند که زبان و تفکر را دو سیستم موازی و مستقل میداند که در عین تعامل، میتوانند بدون یکدیگر نیز عمل کنند.

تفکر بدون زبان (Non-linguistic Thought): انسانها میتوانند مسائل پیچیدهای را حل کنند، بدون اینکه لزوماً کلمات یا جملاتی را در ذهن خود زمزمه کنند. مثال بارز آن، درک مفاهیم فضایی، حل مسائل ریاضی پیچیده در ذهن، یا درک روابط بصری است. هنرمندان، موسیقیدانان و مهندسان اغلب از «تفکر تصویری» یا «تفکر حسی» استفاده میکنند که فاقد برچسبهای زبانی مستقیم است.

زبان بدون تفکر: در مقابل، افراد میتوانند به راحتی جملاتی را تولید کنند که از نظر دستوری و نحوی صحیح هستند، اما فاقد عمق معنایی یا استدلال منطقی باشند. این دقیقاً همان چیزی است که LLMها در آن مهارت دارند: تولید توالیهای کلماتی که آماری بیشترین احتمال را دارند که در یک زمینه خاص ظاهر شوند، بدون اینکه متکی بر مدل درونی جهان باشند.

مطالعات تصویربرداری مغزی و مثالهای بالینی

شواهد محکمی از عصبشناسی وجود دارد که نشان میدهد فرآیندهای زبانی و فرآیندهای استدلالی و شناختی در نواحی متفاوتی از مغز پردازش میشوند، هرچند که این نواحی به شدت با هم تعامل دارند.

- مطالعات fMRI و PET Scan: تصویربرداریهای عملکردی مغز (fMRI) نشان میدهند که فعالیتهای مرتبط با درک معنا و تولید زبان (مناطقی مانند ناحیه بروکا و ورنیکه) با فعالیتهای مرتبط با استدلال انتزاعی، برنامهریزی و حل مسئله که عمدتاً در قشر پیشپیشانی (Prefrontal Cortex – PFC) رخ میدهند، تفاوتهایی اساسی دارند. در حالی که زبان میتواند برای تسهیل استدلال استفاده شود، فرآیند استدلال و تصمیمگیری میتواند مستقل از فرآیندهای تولید زبان صورت پذیرد.

- بیماران با آسیبهای زبانی (Aphasia): یکی از قویترین شواهد، مطالعه بیمارانی است که دچار آسیبهای مغزی شدهاند. بیمارانی که دچار آفازی (Aphasia) هستند، اغلب در تولید یا درک زبان (نوشتاری یا گفتاری) دچار مشکل جدی هستند، اما تواناییهای شناختی غیرزبانی آنها، مانند استدلال منطقی، حل مسائل تصویری، درک روابط فضایی، و حتی مهارتهای موسیقی یا هنری، ممکن است دستنخورده باقی بماند یا تنها جزئی آسیب ببیند. برای مثال، بیمارانی با آسیب شدید در ناحیه بروکا ممکن است نتوانند جملات پیچیده بسازند، اما همچنان قادرند مسائل فیزیکی یا هندسی را با موفقیت حل کنند. این نشان میدهد که زیربنای «تفکر» از شبکه عصبی مرتبط با «زبان» قابل تفکیک است.

- حل مسئله غیرزبانی (Non-verbal Problem Solving): مطالعات بر روی کودکان خردسال و حتی برخی حیوانات هوشمند نشان میدهد که آنها تواناییهای حل مسئله و درک علت و معلول را پیش از کسب مهارتهای زبانی کامل نشان میدهند. یک کودک نوپا میتواند یاد بگیرد که با استفاده از ابزاری، اسباببازی خود را از دسترس خارج کند، این درک از «ابزار» و «هدف» بدون نیاز به دستور زبان پیچیده شکل میگیرد.

این شواهد علوم شناختی مبنای محکمی برای نقد رویکردهای هوش مصنوعی مبتنی بر مدلهای زبانی صرف است. LLMها اساساً سیستمهای پردازش و تولید متن هستند؛ آنها در حوزه زبان میدرخشند، اما فقدان تجربه زیسته، درک فیزیکی و توانایی مدلسازی جهان به شکل غیرزبانی، آنها را از تفکر واقعی جدا میسازد.

چرا مدلهای زبانی نمیتوانند به تفکر واقعی برسند؟

مدلهای زبانی بزرگ (LLMs) بر اساس یک معماری خاص به نام ترانسفورمر (Transformer) ساخته شدهاند که برای پیشبینی کلمه بعدی در یک دنباله طراحی شدهاند. این معماری، هرچند در انجام وظیفه خود بسیار ماهر است، اما دارای محدودیتهای ذاتی است که مانع از رسیدن به هوش عمومی (AGI) میشود. LLMها ماشینهای «نشانهدهی آماری» (Statistical Pattern Matchers) هستند، نه «موجودات متفکر».

معماری LLM و محدودیتهای ذاتی آن

هسته اصلی یک LLM، مکانیسم توجه (Attention Mechanism) و شبکههای عصبی عظیم آن است که بر روی میلیاردها پارامتر آموزش داده شدهاند. این مدلها میلیاردها «وزن» را یاد میگیرند که نشاندهنده روابط آماری بین کلمات و عبارات در مجموعه دادههای آموزشی عظیم (اغلب کل اینترنت) هستند.

چالش ۱: تقلید در برابر درک (Syntax vs. Semantics):

LLMها در یادگیری نحو (Syntax) و ساختار زبان بسیار عالی عمل میکنند. آنها میتوانند جملات ساختارمند، متقاعدکننده و از نظر دستوری صحیح تولید کنند. اما این مهارت صرفاً مبتنی بر یادگیری روابط آماری است. آنها «معنا» (Semantics) را به همان شیوهای که انسانها درک میکنند (از طریق ارتباط با جهان واقعی)، درک نمیکنند. LLMها صرفاً میدانند که کلمه ‘سیب’ معمولاً در کنار کلماتی مانند ‘قرمز’، ‘میوه’ و ‘خوردن’ ظاهر میشود، اما هیچ درکی از طعم، وزن، یا شکل سهبعدی یک سیب ندارند. آنها «کلمات» را دستکاری میکنند، نه «مفاهیم».

چالش ۲: عدم وجود مدل جهان (Lack of World Model):

تفکر انسان عمیقاً وابسته به ساختن و حفظ یک «مدل ذهنی» یا «مدل جهان» است. این مدل یک ساختار درونی است که قوانین فیزیک، علیت، قصدیت بازیگران و روابط فضایی را شبیهسازی میکند. ما میتوانیم در ذهن خود پیشبینی کنیم که اگر یک لیوان آب را روی لبه میز بگذاریم، چه اتفاقی خواهد افتاد (میافتد).

LLMها فاقد این مدل جهان هستند. آنها دادههای ورودی را به یک نمایش عددی تبدیل میکنند و بر اساس احتمالات آماری، دنباله خروجی را تولید میکنند. این فرآیند شبیه به حدس زدن حرکت بعدی در یک بازی شطرنج بر اساس مشاهده هزاران بازی قبلی است، نه درک استراتژی یا قوانین فیزیکی صفحه بازی. اگر از یک LLM بخواهید یک سناریوی فیزیکی پیچیده را شبیهسازی کند، ممکن است پاسخهایی تولید کند که کاملاً با قوانین فیزیک در تضاد باشند، زیرا فاقد چارچوب علّی برای ارزیابی درستی پاسخ است.

نبود مدل جهان، نبود ادراک، نبود علیت

محدودیت اساسی LLMها در نداشتن «تجربه زیسته» است. هوش واقعی در تعامل با دنیای فیزیکی شکل میگیرد. ما از طریق بینایی، لامسه، شنوایی و حرکت، یاد میگیریم که اشیاء چگونه رفتار میکنند، چگونه حرکت میکنند و چه نتایجی از اقدامات ما حاصل میشود.

- ادراک (Perception): LLMها از طریق دادههای متنی، دانش را جذب میکنند. آنها نمیتوانند به طور مستقیم ببینند، بشنوند یا لمس کنند. این فقدان ورودی حسی (Embodiment) به این معناست که مفاهیم آنها کاملاً انتزاعی و مبتنی بر ارتباطات متنی هستند، نه ارتباطات با واقعیت فیزیکی.

- علیت (Causality): درک علیت (اینکه چرا چیزی اتفاق میافتد) سنگ بنای تفکر علمی و روزمره است. LLMها میتوانند روابط همبستگی (Correlation) را در دادهها شناسایی کنند (“باران میآید، پس زمین خیس میشود”)، اما آنها مفهوم علیت را درک نمیکنند. برای یک LLM، “باران آمدن” و “زمین خیس شدن” صرفاً دو توکن هستند که اغلب در نزدیکی یکدیگر ظاهر میشوند. آنها نمیتوانند پیشبینی کنند که اگر در یک اتاق خشک، یک سطل آب را روی زمین خالی کنند، چه اتفاقی میافتد، مگر اینکه این سناریو به صورت کلماتی در دادههای آموزشی آنها وجود داشته باشد.

- استدلال (Reasoning): استدلال نیاز به دستکاری نمادها در یک فضای معنایی منسجم دارد. در حالی که LLMها میتوانند زنجیرهای از استدلالها را تقلید کنند (Chain-of-Thought Prompting)، این فرآیند به سرعت در مسائل چند مرحلهای یا مسائلی که نیاز به محاسبات دقیق و پایبندی به قوانین منطقی دارند، فرو میپاشد. این تقلید، اغلب یک توالی کلمات است که به نظر میرسد منطقی است، نه یک استدلال واقعی.

دیدگاه بنجامین رایلی؛ نقد رؤیای مدیران فناوری

بنجامین رایلی (Benjamin Riley)، فعال حوزه هوش مصنوعی و بنیانگذار مؤسسه غیرانتفاعی Kairos Society، نقدهای بسیار معتبری را به جریان اصلی هوش مصنوعی وارد کرده است که بر محدودیتهای ذاتی LLMها در مسیر دستیابی به AGI تأکید دارد. دیدگاه او، که غالباً در انتقاد از مدلهای زبانی کنونی مطرح میشود، بر این اساس استوار است که ما در حال سرمایهگذاری هنگفت بر روی سیستمی هستیم که از نظر شناختی دچار نقصهای بنیادی است.

زبان ابزار فکر است، نه خود فکر

رایلی و همفکرانش استدلال میکنند که تمرکز بیش از حد بر روی بزرگسازی مدلهای زبانی (Scaling Laws) منجر به این توهم شده است که افزایش اندازه مدل و دادههای آموزشی، به طور خودکار منجر به ظهور هوش واقعی خواهد شد. این دیدگاه، که گاهی به عنوان «سرمایهداری توهم» (The Illusionary Capitalism) توصیف میشود، بر اساس یک فرض غلط بنا شده است: اگر یک سیستم بتواند زبان انسان را به طور کامل تقلید کند، پس باید فکر کند.

تحلیل دیدگاه رایلی و تکامل آن:

رایلی تأکید میکند که زبان صرفاً یک «رابط» (Interface) برای بیان فکر است، نه محتوای خود فکر. یک LLM تنها با استفاده از ساختار زبان، میتواند پاسخهای بسیار منسجم تولید کند، اما این ساختار فاقد «پایگاه معنایی» است که انسانها از طریق تجربه و تعامل با جهان به آن دست مییابند.

مثال تکمیلی: یادگیری دستور پخت پیچیده:

فرض کنید یک LLM میلیاردها دستور پخت غذا را مطالعه کرده باشد. میتواند یک دستور پخت بسیار پیچیده برای یک کیک سه طبقه با تزئینات خاص تولید کند که کاملاً درست و قابل اجرا به نظر برسد. این کار نیازمند درک نحو دستور زبان آشپزی است. با این حال، اگر از یک آشپز (دارای مدل جهان) بپرسید: «اگر در این دستور پخت، به جای پودر قند، از نمک استفاده کنم چه میشود؟» آشپز فوراً میداند که نتیجه یک کیک شور و غیرقابل خوردن خواهد بود، زیرا درک علیت و واکنش مواد شیمیایی (مدل جهان فیزیکی) را دارد. LLM فقط میتواند حدس بزند که در دادههای آموزشی، پس از عبارت “استفاده از نمک”، چه کلماتی معمولاً میآیند، که ممکن است منجر به پاسخهای بیمعنی یا حتی خطرناک شود.

رایلی بر این باور است که ما در حال بهینهسازی سیستمی هستیم که ذاتاً در دام «تقلید» باقی خواهد ماند. او اشاره میکند که در دنیای واقعی، چالشهای بزرگ بشری (تغییرات اقلیمی، فیزیک جدید، درمان بیماریها) نیاز به فراتر رفتن از دانش موجود (که LLMها به آن دسترسی دارند) و ایجاد دانش جدید دارند. LLMها متخصص در جمعآوری و بازترکیب دانش موجود هستند، نه خلق دانش بنیادی.

این نقد به طور خاص مدیران فناوری را هدف قرار میدهد که به دلیل موفقیتهای کوتاهمدت تجاری LLMها، مسیر تحقیقات را به سمت مقیاسبندی هر چه بیشتر این معماریها هدایت میکنند، در حالی که نیاز به رویکردهای بنیادینتر برای رسیدن به AGI نادیده گرفته میشود.

یان لکون و مفهوم Model of the World

یان لکون (Yann LeCun)، یکی از پیشگامان یادگیری عمیق و مدیر ارشد هوش مصنوعی متا (Meta AI)، منتقد سرسخت رویکرد فعلی LLMها برای دستیابی به AGI است. لکون به صراحت اعلام کرده است که مدلهای زبانی بزرگ کنونی، هر چقدر هم بزرگ شوند، هرگز به هوش عمومی دست نخواهند یافت، زیرا فاقد عنصر حیاتی «مدل جهان» هستند.

چرا AGI از مسیر LLMها عبور نمیکند

لکون استدلال میکند که هوش، چه در انسان و چه در حیوانات، نیازمند توانایی پیشبینی آینده، برنامهریزی و درک روابط علت و معلولی در یک محیط فیزیکی پویا است. این نیازمند یک مدل درونی از جهان است که بتواند شبیهسازیهای ذهنی را انجام دهد.

معماری LLM در مقابل مدلسازی جهان:

LLMها با استفاده از یادگیری خودنظارتی (Self-Supervised Learning) بر روی دادههای متنی آموزش میبینند. هدف آنها یادگیری احتمال وقوع یک توکن بعدی است. این فرآیند به آنها امکان میدهد تا ساختار زبان را بیاموزند. در مقابل، هوش نیازمند یادگیری مبتنی بر تعامل (Interaction-based Learning) است که در آن عامل هوشمند باید در محیط عمل کند، واکنشها را مشاهده کند و مدل درونی خود را بر اساس بازخورد محیط بهروز کند.

لکون به طور مداوم بر نیاز به معماریهایی تاکید میکند که بتوانند «ساختارهای پنهان» جهان را کشف کنند. این ساختارها شامل موارد زیر هستند:

- درک سهبعدی و فیزیکی: انسانها به طور ذاتی میدانند که اجسام جامد هستند، گرانش وجود دارد و اشیاء نمیتوانند از میان یکدیگر عبور کنند. این درک فیزیکی در مدلهای زبانی وجود ندارد. آنها فقط میدانند که در جملات، “توپ” و “دیوار” اغلب با افعالی مانند “برخورد کردن” یا “افتادن” مرتبط هستند.

- قصدیت و انگیزهها (Intentionality): تفکر انسان شامل درک نیتها، اهداف و انگیزههای خود و دیگران است. LLMها میتوانند نیتها را بر اساس متون پیشبینی کنند، اما خود فاقد هرگونه نیت یا هدف درونی هستند؛ هدف آنها صرفاً تولید پاسخ با کمترین خطای پیشبینی است.

- مدلسازی علی و معلولی (Causal Modeling): لکون معتقد است که کلید AGI، ساخت یک «مدل جهان» است که بتواند سناریوهای «چه میشد اگر» (What-if Scenarios) را اجرا کند. این نیازمند یک مکانیسم استنتاجی است که بتواند روابط علت و معلولی را استخراج کند، نه صرفاً روابط همبستگی آماری.

مقایسه معماریهای زبانی و معماریهای مبتنی بر مدلسازی جهان:

ویژگیLLMهای فعلی (مانند GPT-4)معماریهای آیندهنگر (پیشنهاد لکون)تمرکز اصلیپیشبینی توکن بعدی بر اساس توالی ورودیساخت مدل درونی قابل تعمیم از جهاننحوه یادگیریخودنظارتی بر روی دادههای متنی ایستایادگیری از طریق تعامل (یادگیری تقویتی/یادگیری فعال)مدل جهانغایب (تنها دانش سطحی آماری)ضروری (شامل فیزیک، علیت، فضای سهبعدی)استدلالتقلید از استدلالهای مشاهده شده در دادههاتوانایی اجرای شبیهسازیهای ذهنی و پیشبینیخلاقیتبازترکیب و ترکیب مجدد الگوهای موجودتولید ایدههای نوآورانه مبتنی بر درک زیربنایی

لکون و همکارانش بر توسعه معماریهایی مانند World Models تمرکز دارند که در آنها یک مدل پیشبینیکننده (Predictive Model) به طور مداوم در حال بهروزرسانی و بهبود مدل درونی خود از جهان است، حتی در غیاب بازخورد زبانی صریح. این رویکرد، که به ریشههای ادراکی و عملی هوش نزدیکتر است، مسیری متفاوت از مسیر صرفاً زبانی LLMها را ترسیم میکند.

محدودیت خلاقیت در مدلهای زبانی

یکی از اصلیترین ادعاهای پشتیبانان LLMها این است که این مدلها خلاقیت قابل توجهی از خود نشان میدهند، چه در سرودن شعر، چه در تولید کدها یا خلق داستانهای جدید. اما آیا این خلاقیت واقعاً «خلاقیت» به معنای انسانی آن است؟ تحلیلهای روانشناختی و فلسفی نشان میدهند که خلاقیت LLMها در مرز تقلید و بازترکیب گیر افتاده است.

تحلیل نظریه دیوید کراپلی (David Cropley)

دیوید کراپلی، روانشناس برجسته در زمینه خلاقیت، چارچوبی برای ارزیابی خلاقیت ارائه میدهد که بر اساس آن، خلاقیت واقعی باید هم نوآورانه (Novel) باشد و هم مفید (Useful) یا مناسب (Appropriate) برای حل مسئله یا ایجاد ارزش. خلاقیتهای انسانی معمولاً شامل تولید ایدههایی هستند که نه تنها جدیدند، بلکه ساختارهای پیشین را به شیوهای بدیع میشکنند یا بازتعریف میکنند.

خلاقیت LLM: ترکیب مجدد پیچیده (Complex Recombination):

LLMها در زمینهای که کراپلی آن را «خلاقیت تجمعی» (Accumulative Creativity) مینامد، بسیار خوب عمل میکنند. آنها میتوانند حجم عظیمی از دانش و سبکهای هنری را جذب کرده و با ترکیب مجدد آنها، خروجیهایی تولید کنند که از نظر ترکیب الگوها، برای انسان تازگی داشته باشد.

مثال: LLM میتواند یک رمان علمی-تخیلی بنویسد که عناصر سبک داستانی چارلز دیکنز را با مفاهیم فیزیک کوانتوم ترکیب کند. این ترکیب برای ما نوآورانه به نظر میرسد، زیرا چنین ترکیبی در دادههای آموزشی به ندرت یا هرگز وجود نداشته است.

محدودیت: فقدان استقلال در ابداع و شکستن چارچوبها:

مشکل اینجاست که LLMها نمیتوانند چارچوبهای اصلی را بشکنند؛ آنها قادر به «تولید چیزی کاملاً خارج از مجموعه دادههای آموزشی» نیستند. خلاقیت واقعی اغلب نیازمند یک «جهش ادراکی» (Cognitive Leap) است که مستلزم کنار گذاشتن الگوهای موجود و پذیرش یک پارادایم کاملاً جدید است.

- خلاقیت مبتنی بر جهان: خلاقیت انسانی از درک عمیق از محدودیتهای فیزیکی، اجتماعی و اخلاقی جهان سرچشمه میگیرد. برای مثال، زمانی که یک هنرمند مادهای جدید را کشف میکند یا یک دانشمند، فرضیهای را مطرح میکند که با دانش پیشین در تضاد است، این خلاقیت از درک محدودیتها و تلاش برای فراتر رفتن از آنها ناشی میشود. LLMها این محدودیتها را صرفاً به عنوان توکنهایی که باید با آنها بازی کنند، درک میکنند.

- خلاقیت هدفمند و انگیزشی: خلاقیت انسان اغلب با انگیزههای درونی، نیاز به بیان، حل یک مشکل عاطفی یا فکری خاص همراه است. LLMها فاقد این موتور محرک هستند. «خلاقیت» آنها تابعی از تابع زیان (Loss Function) و دستورالعملهای ورودی (Prompt) است.

تحلیل کراپلی نشان میدهد که LLMها در «خلاقیت اکتشافی» (Exploratory Creativity) عالی هستند (جستجو در فضای راهحلهای موجود)، اما در «خلاقیت تحولآفرین» (Transformational Creativity) که به ایجاد پارادایمهای کاملاً جدید میپردازد، شکست میخورند. آنها میتوانند بهترین و عجیبترین ترکیبهای ممکن از چیزهایی را که قبلاً وجود داشتهاند ایجاد کنند، اما نمیتوانند چیزی را خلق کنند که فراتر از تمام «دادههای آموزشی» باشد.

پیامدهای علمی و فلسفی؛ چرا LLMها جایگزین دانشمندان نمیشوند؟

اگر LLMها نتوانند جهان را مدلسازی کنند، استدلال علّی انجام دهند و به خلاقیت تحولآفرین دست یابند، این سوال مطرح میشود که نقش آنها در حل بزرگترین چالشهای بشری چیست و چرا نمیتوانند جایگزین دانشمندان، فلاسفه یا مهندسان نوآور شوند.

مرز نوآوری و مرز تقلید

وظیفه اصلی یک LLM، مانند یک دستیار پژوهشی بسیار پرکار، کمک به تسریع فرآیند جمعآوری و سنتز اطلاعات موجود است. آنها میتوانند مقالات علمی را خلاصه کنند، کدها را دیباگ کنند یا پیشینههای تاریخی یک موضوع را گردآوری نمایند. در این سطح، LLMها ابزارهای فوقالعادهای برای افزایش کارایی (Efficiency) هستند.

با این حال، علم و نوآوری بنیادی (Fundamental Innovation) نیازمند فراتر رفتن از آنچه میدانیم است. این فرآیند شامل سه مرحله اصلی است که LLMها در آنها دچار مشکل میشوند:

۱. مشاهده و شکلدهی به سؤال (Formulating the Question):

دانشمندان بزرگ معمولاً با مشاهده پدیدههایی که با مدلهای موجود سازگار نیستند، کار خود را آغاز میکنند. برای مثال، آلبرت اینشتین مشاهده کرد که فیزیک نیوتنی نمیتواند رفتار نور را در سرعتهای بالا توضیح دهد. این مشاهده نیاز به «نگاه متفاوت» دارد. LLMها ممکن است گزارشهایی درباره این ناهنجاریها تولید کنند، اما توانایی آنها برای «احساس کردن» عدم کفایت یک نظریه و طرح یک سؤال جدید و بنیادی، بسیار محدود است.

۲. ساخت مدل مفهومی (Conceptual Model Building):

این مرحله نیازمند انتزاع، مدلسازی جهان و ایجاد ساختارهای ریاضی یا منطقی جدید است که پدیدهها را توضیح دهد. همانطور که بحث شد، LLMها فاقد مدل جهان داخلی هستند. آنها نمیتوانند به طور مستقل یک ساختار ریاضی جدید ایجاد کنند تا یک رابطه علّی ناشناخته را توضیح دهند. آنها میتوانند معادلات شناخته شده را تایپ کنند یا حتی فرمولهای ساختارمندی را تولید کنند که شبیه به ریاضیات به نظر میرسند، اما فاقد عمق و پشتوانه مدلسازی فیزیکی هستند.

۳. اعتبارسنجی و تعمیم (Validation and Generalization):

یک مدل علمی باید بتواند پیشبینیهای جدیدی ارائه دهد که در آزمایشهای آینده تأیید شوند. این فرآیند نیازمند تفکر علّی است تا بتواند نتایج آزمایشهای جدید را پیشبینی کند. LLMها صرفاً میتوانند پیشبینیهایی را تولید کنند که «شبیه» پیشبینیهای دانشمندان به نظر میرسند، اما مکانیسم اساسی برای ارزیابی اعتبار پیشبینیهای خارج از دادههای موجود را ندارند.

LLMها در مرز دادههای آموزشی (The Boundary of Training Data):

این ماشینها در تولید محتوایی که درون «بسته دادههای آموزشی» آنها قرار دارد، عالی هستند. هر چه سوال از دادههای آموزشی دورتر شود، عملکرد LLMها کاهش مییابد و احتمال تولید محتوای موهوم (Hallucination) یا استدلالهای متناقض افزایش مییابد. برای کشف فیزیک جدید، درمانهای نوین پزشکی، یا اصول جدید در فلسفه، باید فراتر از دانش انباشته شده حرکت کرد. LLMها در این مرز بیرونی، که مرز «دانش واقعی» است، بسیار ضعیف عمل میکنند.

تحلیل مفهوم «ماشین استعاره مرده» (The Dead Metaphor Machine)

مفهوم «ماشین استعاره مرده» به این ایده اشاره دارد که LLMها در نهایت به ابزارهایی تبدیل میشوند که به شکل فزایندهای پیچیده، اما در ذات خود، تکرارکننده الگوهای قدیمی هستند. کلمه «استعاره» در اینجا به معنای قدرت زبانی است که توانسته است الگوهای زیربنایی جهان را بازتاب دهد. اما در LLMها، این استعاره «مرده» است زیرا هیچ درکی از آنچه استعاره به آن اشاره دارد، وجود ندارد.

این مدلها میتوانند استعارههای زبانی را به طور بینقص تکرار کنند، اما نمیتوانند استعارهای جدید بسازند که بر اساس یک بینش عمیقتر از واقعیت بنا شده باشد. آنها در حال بازنمایی استعارههای ما هستند، نه ساختن استعارههای جدید برای جهان.

به همین دلیل، در حالی که LLMها میتوانند در نوشتن مقالات آکادمیک، نوشتن طرحهای اولیه دارو یا کمک به توسعه نرمافزارهای موجود مفید باشند، آنها نمیتوانند نظریه نسبیت یا معماری نوین کامپیوتر را کشف کنند، چرا که این کار نیازمند توانایی تفکر عمیق و غیرزبانی است که LLMها فاقد آن هستند.

مقایسه معماریهای زبانی و معماریهای مبتنی بر مدلسازی جهان

همانطور که بحث شد، شکاف اصلی بین LLMهای فعلی و AGI در نوع معماری و مدلسازی جهان است. در حالی که LLMها بر پایه «زبان به مثابه داده» بنا شدهاند، رویکردهای دیگر، اغلب الهام گرفته از بیولوژی و علوم شناختی، بر «جهان به مثابه مدل» تأکید دارند.

معماریهای زبانی (LLMs): مبتنی بر پیشبینی توکن

معماری ترانسفورمر، که قلب LLMها است، اساساً یک ماشین احتمالاتی بسیار پیچیده است که در فضای زبانی عمل میکند.

[ P(w_t | w_1, w_2, \dots, w_{t-1}) ]

که در آن ( P ) احتمال کلمه بعدی ( w_t ) با توجه به توالی کلمات قبلی است. این مدل به طور کامل بر روی دادههای ورودی تعریف میشود و فاقد یک مدل پویا و فعال از جهان است.

نقاط قوت:

- قابلیت پردازش و تولید حجم عظیمی از متن.

- درک و بازتولید ساختارهای نحوی پیچیده.

- توانایی سنتز دانش موجود به شیوههای جدید.

نقاط ضعف:

- عدم درک علیت و روابط فیزیکی.

- آسیبپذیری شدید در برابر توهم و محتوای نادرست.

- وابستگی کامل به دادههای آموزشی و ناتوانی در یادگیری از تعاملات جدید بدون بازآموزی گسترده.

معماریهای مبتنی بر مدلسازی جهان (World Models): مبتنی بر استنتاج و شبیهسازی

رویکردی که توسط محققانی مانند یان لکون پیشنهاد میشود، بر ساخت سیستمهایی متمرکز است که میتوانند یک «مدل پیشبین» (Predictive Model) از جهان ایجاد کنند. این مدلها اغلب از طریق یادگیری تقویتی (Reinforcement Learning) یا روشهای مشابهی که نیازمند تعامل فعال با محیط (شبیهسازی شده یا واقعی) هستند، آموزش میبینند.

عناصر کلیدی معماری مدل جهان:

- ادراک (Perception Module): دریافت اطلاعات حسی (بینایی، لمس، شنیدن) از محیط. در LLMها، این نقش توسط دادههای متنی ایفا میشود.

- مدل جهان (World Model Module): این هسته مرکزی است که قوانین فیزیک، علیت و ویژگیهای پایداری اشیاء را یاد میگیرد. این مدل میتواند سناریوها را شبیهسازی کند.

- ماژول برنامهریزی و اقدام (Planning/Action Module): این ماژول از مدل جهان برای پیشبینی نتایج اقدامات مختلف استفاده میکند و بهترین مسیر برای رسیدن به هدف را انتخاب میکند.

- ماژول یادگیری/بهروزرسانی (Learning/Update Module): این ماژول مدل جهان را بر اساس نتایج واقعی (یا شبیهسازی شده) اقدامات خود بهروز میکند.

[ \text{State}_{t+1} = f(\text{State}_t, \text{Action}_t) ]

در این فرمولبندی، تابع ( f ) مدل جهان است که یاد میگیرد چگونه حالتهای بعدی جهان را بر اساس حالت فعلی و عملی که عامل انجام میدهد، پیشبینی کند.

نقاط قوت:

- توانایی استدلال علّی و برنامهریزی بلندمدت.

- یادگیری کارآمد از طریق تعامل (یادگیری با دیدن تنها چند مثال).

- استخراج دانش بنیادی در مورد قوانین جهان.

نقاط ضعف:

- چالشهای مهندسی در ساخت مدلهای جهان در مقیاس بزرگ.

- پیچیدگی در ادغام دانش زبانی غنی با مدلهای فیزیکی.

- نیاز به محیطهای تعاملی برای آموزش (که جمعآوری آنها دشوار است).

تکامل احتمالی: یک سیستم ترکیبی:

آینده AGI احتمالاً در ترکیب این دو معماری خواهد بود. یک سیستم AGI واقعی احتمالاً از یک LLM برای پردازش و تولید زبان (به عنوان واسط کاربری و دانش تجمعی) بهره خواهد برد، اما این LLM باید توسط یک «مدل جهان» قدرتمند پشتیبانی شود تا بتواند استدلالهای علّی انجام دهد، برنامهریزی کند و درک عمیقی از واقعیت داشته باشد. این رویکرد تلاش میکند تا نقاط قوت پردازش زبان را با نیاز به درک فیزیکی و علّی ترکیب کند.

آینده هوش مصنوعی پس از LLMها

اگر LLMها به AGI نرسند، پس چه مسیری برای دستیابی به هوش عمومی وجود دارد؟ آینده هوش مصنوعی به احتمال زیاد نیازمند جهشهای پارادایمی در معماریهای محاسباتی و الگوریتمهای یادگیری است که فراتر از مدلهای زبانی کنونی عمل کنند.

چه فناوریهایی ممکن است فضا را تغییر دهند؟

مسیر پیش رو، تمرکز بر سیستمهایی است که میتوانند با محیط تعامل داشته باشند، مدلهای علّی بسازند و دانش خود را به صورت پویا سازماندهی کنند. این مسیر، هوش مصنوعی را از یک ابزار پردازش متن به یک عامل فعال در دنیای واقعی تبدیل میکند.

۱. هوش مصنوعی ادراکی-عملی (Embodied AI):

همانطور که یان لکون بر آن تأکید دارد، هوش واقعی وابسته به فیزیک است. رباتهایی که در محیطهای واقعی آموزش میبینند و میتوانند به طور مستقل یاد بگیرند که چگونه اشیاء را دستکاری کنند، مدلهای جهان خود را توسعه خواهند داد. این مدلها نیازمند درک سهبعدی و توانایی پیشبینی فیزیکی هستند.

۲. معماریهای مبتنی بر حافظه فعال و استدلال نمادین (Symbolic Reasoning and Active Memory):

LLMها در استدلال نمادین – دستکاری مفاهیم انتزاعی مانند «مفهوم عدالت»، «تعریف یک تابع ریاضی» یا «یک قانون حقوقی» – ضعف نشان میدهند زیرا اغلب مجبورند آنها را از طریق الگوهای متنی تقلید کنند. ترکیب قابلیتهای یادگیری عمیق (Deep Learning) با سیستمهای استدلال نمادین سنتی (Symbolic AI) میتواند به هوش مصنوعی اجازه دهد تا ساختارهای منطقی و قوانین را به طور صریح یاد بگیرد و اعمال کند، نه فقط اینکه آنها را در متن مشاهده کند.

۳. مدلهای مبتنی بر یادگیری پیوسته و افزایشی (Continual/Lifelong Learning):

انسانها در طول زندگی خود یاد میگیرند و دانش جدید را به دانش قبلی اضافه میکنند بدون اینکه دانش قبلی را فراموش کنند (که در شبکههای عصبی فعلی به عنوان «فراموشی فاجعهبار» (Catastrophic Forgetting) شناخته میشود). سیستمهای آینده باید بتوانند به طور پیوسته و بدون نیاز به بازآموزی کامل بر روی کل مجموعه دادههای قبلی، یاد بگیرند و دانش خود را ادغام کنند.

۴. هوش مصنوعی چندوجهی با تمرکز بر تعامل حسی (Multimodal AI with Sensory Focus):

اگرچه مدلهای چندوجهی کنونی (مانند GPT-4V که متن و تصویر را درک میکند) گامهایی رو به جلو هستند، اما آینده نیازمند مدلهایی است که بتوانند ورودیهای حسی متنوع (صوت، ویدئو، دادههای لمسی، و حتی دادههای درونمغزی شبیهسازی شده) را به شیوهای یکپارچه پردازش کنند و از طریق این تعاملات، مدل جهان خود را بسازند.

این رویکردها نشان میدهند که LLMها ممکن است نقطه پایان مسیر AGI نباشند، بلکه یک مرحله واسط برای دستیابی به فهم عمیقتر از نحوه عملکرد هوش باشند.

جمعبندی نهایی؛ ماشینهایی که فکر نمیکنند

مدلهای زبانی بزرگ (LLMs) دستاوردهای مهندسی فوقالعادهای هستند که توانایی ما را در تعامل با ماشینها متحول کردهاند. آنها در تولید زبان، تقلید سبکهای نوشتاری، و پاسخگویی به طیف وسیعی از سوالات به طرز شگفتانگیزی ماهرند. این موفقیتها اغلب منجر به توهم درک (Illusion of Understanding) در کاربران میشود.

با این حال، تحلیلهای عمیق از منظر علوم شناختی، عصبشناسی و فلسفه ذهن، نشان میدهد که این سیستمها فاقد ویژگیهای اساسی هوش واقعی (Real Intelligence) هستند:

- فقدان مدل جهان: آنها فاقد درک علّی، فیزیکی و فضایی از نحوه کارکرد جهان هستند.

- وابستگی به آمار: خروجی آنها صرفاً بازتابی از روابط آماری مشاهده شده در دادههای آموزشی است، نه نتیجه استنتاج یا درک مفاهیم.

- محدودیت در خلاقیت تحولآفرین: آنها قادر به شکستن پارادایمها و ابداع دانش کاملاً جدید نیستند؛ خلاقیت آنها در مرز تقلید پیچیده متوقف میشود.

همانطور که بنجامین رایلی و یان لکون اشاره کردهاند، تا زمانی که هوش مصنوعی بر پایه سیستمی بنا نشود که بتواند جهان را مدلسازی کند، با آن تعامل داشته باشد و بر اساس درک علّی استدلال کند، صرفاً «ماشینهای زبانی» خواهند بود، نه «ماشینهای متفکر».

آینده AGI نه در بزرگتر کردن شبکههای زبانی، بلکه در ساخت معماریهایی است که بتوانند مانند مغز عمل کنند: ساخت مدلهای درونی، انجام شبیهسازیهای ذهنی و یادگیری مستمر از تعامل با واقعیت. LLMها ابزارهای قدرتمندی هستند، اما مسیر به سوی AGI نیازمند درک عمیقتری از ماهیت تفکر انسان است که فراتر از صرف دستکاری کلمات عمل میکند.

پرسشهای متداول (FAQ)

۱. آیا ممکن است LLMها در آینده به هوش واقعی برسند؟

پاسخ به این سوال بستگی به این دارد که منظور از «آینده» و «هوش واقعی» چیست. در مسیر فعلی، یعنی صرفاً بزرگسازی معماری ترانسفورمر و دادههای آموزشی، احتمال رسیدن به AGI بسیار کم است. هوش واقعی نیازمند ظرفیتهای ادراکی، علّی و مدلسازی جهان است که در معماری فعلی LLMها به طور ذاتی وجود ندارد. برای رسیدن به AGI، نیاز به یک تغییر پارادایم در معماری و ادغام آن با مدلهای جهان (World Models) و سیستمهای یادگیری فعال است.

۲. چرا برخی افراد تصور میکنند LLMها «میفهمند»؟

این تصور اغلب ناشی از پدیدهای به نام «توهم درک» (Illusion of Understanding) است. LLMها در تولید زبانی که از نظر نحوی و بافتاری بسیار شبیه به فهم انسانی است، مهارت دارند. وقتی یک LLM پاسخی بسیار منسجم و منطقی ارائه میدهد، مغز انسان تمایل دارد به طور پیشفرض فرض کند که پشت این پاسخ، یک درک معنایی نیز وجود دارد. این توانایی در تقلید ساختار زبان، به جای درک معنای آن، باعث فریب مخاطب میشود.

۳. آیا مدلهای چندوجهی (Multimodal Models) میتوانند راهحلی برای AGI باشند؟

مدلهای چندوجهی (که میتوانند متن، تصویر و صدا را پردازش کنند) قطعاً گامی مهم در جهت هوش مصنوعی هستند، زیرا به مدلها اجازه میدهند تا با دادههای حسی بیشتری کار کنند و تا حدی فقدان تجربه زیسته را جبران کنند. با این حال، این مدلها هنوز به طور کامل فاقد درک علّی و ساختار مدل جهان هستند. آنها میتوانند تصویر یک سیب را ببینند و آن را با کلمه «سیب» مرتبط کنند، اما مکانیسم داخلی آنها برای پیشبینی فیزیکی تعامل با آن سیب (مثلاً اینکه اگر آن را رها کنیم چه اتفاقی میافتد) همچنان ضعیف است. آنها ابزارهای بهتری برای تقلید هستند، اما نه لزوماً راهحل نهایی AGI.

۴. تفاوت خلاقیت انسانی و خلاقیت مصنوعی (LLM) چیست؟

خلاقیت انسانی اغلب «تحولآفرین» است؛ این توانایی را دارد که پارادایمهای موجود را بشکند و مفاهیم کاملاً جدیدی را ایجاد کند که بر اساس درک عمیق از محدودیتهای جهان و اهداف درونی شکل میگیرد. خلاقیت LLMها عمدتاً «اکتشافی» و «تجمعی» است؛ آنها در ترکیب مجدد و پیچیدهسازی الگوهایی که قبلاً در دادههای آموزشی وجود داشتهاند، بسیار ماهرند. آنها میتوانند نتایج نوآورانهای تولید کنند، اما این نوآوری در چارچوب محدود دادههای آموزشی آنها باقی میماند.

۵. چه چیزی برای ساخت یک AGI واقعی لازم است؟

ساخت یک AGI واقعی احتمالاً نیازمند چند عنصر کلیدی است که در LLMها غایب هستند:

- یک مدل جهان داخلی و علّی: سیستمی که بتواند قوانین فیزیکی و منطقی جهان را درک و شبیهسازی کند.

- تجربه زیسته (Embodiment): تعامل فعال با محیط فیزیکی برای کسب دانش از طریق اقدام و بازخورد.

- یادگیری افزایشی و پیوسته: توانایی یادگیری مداوم بدون فراموشی دانش قبلی.

- ترکیب استدلال نمادین با یادگیری عمیق: برای دستیابی به هر دو سطح استدلال سطح پایین (الگوهای آماری) و سطح بالا (مفاهیم انتزاعی و منطق).