برگ برنده مغز انسان مقابل هوش مصنوعی؛ ترفندی که ماشینها هنوز بلد نیستند

برگ برنده مغز انسان مقابل هوش مصنوعی: فراتر از الگوها، در عمق ترکیببندی

1. نبرد هوش در عصر الگوریتمها

در قلب تمدن مدرن، نبردی خاموش اما بنیادین در جریان است. این نبرد نه میان کشورها یا ایدئولوژیها، بلکه میان دو نوع هوش است: مغز انسان، محصول میلیاردها سال تکامل بیولوژیکی، و هوش مصنوعی (AI)، شاهکار مهندسی سیلیکونی در قرن بیست و یکم. ما در آستانه عصری هستیم که الگوریتمها قادرند در شطرنج، Go، تشخیص تصویر، و حتی تولید محتوا، از بهترین انسانها پیشی بگیرند. اما آیا این پیشی گرفتن، به معنای برتری مطلق است؟ آیا هوش مصنوعی به زودی جایگزین تمامی تواناییهای شناختی ما خواهد شد؟

ظهور مدلهای بزرگ زبانی (LLMs) و شبکههای عصبی عمیق، شور و هیجانی را در جامعه علمی و عمومی ایجاد کرده است که گویی به نقطهای رسیدهایم که هوش عمومی مصنوعی (AGI) در دسترس است. با این حال، هنگامی که صحبت از انعطافپذیری، نوآوری، و توانایی یادگیری مفاهیم جدید با استفاده از دانش قبلی به میان میآید، هوش مصنوعی همچنان لنگ میزند. این شکاف عمیق، ریشه در مکانیزمهای بنیادین پردازش اطلاعات دارد.

این مقاله به بررسی یکی از حیاتیترین نقاط تمایز میپردازد: ترکیببندی شناختی (Compositionality). این توانایی منحصر به فرد مغز انسان برای ترکیب اجزای کوچک دانش برای ساخت مفاهیم و سناریوهای کاملاً جدید، برگ برنده ما در رقابت با هوش مصنوعی است. ما قصد داریم با تحلیل پژوهشهای پیشگام، به ویژه تحقیقات دانشگاه پرینستون درباره فضاهای عصبی مشترک و نحوه استفاده مغز انسان از ترفندهای معماری برای برتری بر الگوریتمهای یادگیری عمیق، این شکاف را کالبدشکافی کنیم. این تحلیل نه تنها برای درک محدودیتهای فعلی هوش مصنوعی ضروری است، بلکه مسیری را برای طراحی نسل بعدی سیستمهای هوشمند الهامگرفته از زیستشناسی ترسیم میکند.

کلیدواژههای سئو: برگ برنده مغز انسان، هوش مصنوعی، ترکیببندی شناختی، AGI، یادگیری ترکیبی، فراموشی فاجعهبار، شبکه عصبی عمیق، معماری مغز.

2. تعریف مسئله: چرا AI در یادگیری چندوظیفهای شکست میخورد؟

مدلهای هوش مصنوعی امروزی، به خصوص در حوزه یادگیری عمیق، در وظایف تخصصگرا عملکرد خیرهکنندهای دارند. یک شبکه عصبی میتواند هزاران تصویر از گربهها را با دقتی باورنکردنی تشخیص دهد، یا متنی طولانی را به زبانی دیگر ترجمه کند. اما چالش زمانی آغاز میشود که این سیستمها باید “چند وظیفهای” شوند، یعنی وظایف مختلفی را که قبلاً آموختهاند، با هم ترکیب کنند یا در یک سیستم واحد مدیریت کنند.

2.1. پارادوکس تخصص در برابر تعمیم

یکی از بزرگترین محدودیتهای شبکههای عصبی مصنوعی این است که غالباً برای یک وظیفه خاص بهینهسازی میشوند. یک شبکه که برای تشخیص چهره آموزش دیده است، اگر با وظیفه تشخیص صدا مواجه شود، عملاً باید از ابتدا آموزش ببیند. حتی در مدلهای چندوجهی (Multimodal)، این ترکیب اغلب سطحی است و نه ساختاری.

این مسئله در یادگیری چندوظیفهای (Multi-Task Learning) مشهودتر است. هنگامی که یک مدل عمیق برای یادگیری همزمان وظیفه A و وظیفه B آموزش داده میشود، اغلب تداخلی در پارامترهای مشترک رخ میدهد. به جای اینکه دانش آموخته شده از A، به B کمک کند، معمولاً تداخل منفی ایجاد میشود که منجر به کاهش عملکرد در هر دو وظیفه میشود. این پدیده در علوم اعصاب کامپیوتری به عنوان “تداخل وظیفه” شناخته میشود.

2.2. ناتوانی در استنتاج انتزاعی پیچیده

مغز انسان میتواند مفاهیم بسیار انتزاعی را درک کند. ما میتوانیم مفهوم “عدالت”، “آزادی” یا حتی یک قیاس پیچیده (مانند قیاسهای استقرایی در فیزیک) را درک کنیم، زیرا میتوانیم اجزای سازنده آنها را در ذهن خود جابجا کنیم.

هوش مصنوعی فعلی عمدتاً بر اساس “شباهت آماری” عمل میکند. یک LLM میتواند جملهای را تولید کند که از لحاظ دستوری و معنایی درست به نظر میرسد، زیرا الگوهای موجود در میلیاردها جمله مشابه را فرا گرفته است. اما اگر ساختار آن جمله را به شکلی بنیادین تغییر دهیم—مثلاً جای فاعل و مفعول را عوض کنیم و انتظار داشته باشیم معنای استنتاجی حفظ شود—AI به سرعت دچار خطا میشود. این نشان میدهد که AI ساختار زیربنایی (Syntax) را میآموزد، اما “معناشناسی ساختاریافته” (Structured Semantics) را نه.

3. آشنایی با مفهوم Compositionality (ترکیببندی شناختی)

ترکیببندی شناختی (Compositionality) اصلی بنیادین در زبانشناسی و فلسفه ذهن است که بیان میکند توانایی ما برای درک و تولید عبارات و مفاهیم بیپایان، ناشی از توانایی ما برای ترکیب اجزای محدود دانش (واژهها، مفاهیم اولیه) به روشهای جدید است.

3.1. تعریف علمی ترکیببندی

از منظر علمی، ترکیببندی به این معناست که معنای یک کل، تابعی است از معنای اجزای سازنده آن و روشی که این اجزا ترکیب شدهاند. برای مثال، مفهوم “گربه سیاه بزرگ” از سه مفهوم مجزا (گربه، سیاه، بزرگ) و دو رابطه ترکیبی (صفت برای اسم، صفت برای صفت) ساخته شده است.

ترکیببندی در انسان:

- اقتصاد در یادگیری: نیازی نیست که تمام ترکیبهای ممکن از مفاهیم را حفظ کنیم. ما تنها نیاز داریم “گربه”، “سیاه”، “بزرگ” و قوانین ترکیب نحوی را بیاموزیم.

- قابلیت تعمیم (Generalization): با آموختن این اجزا، میتوانیم مفاهیمی مانند “فیل آبی کوچک” را درک کنیم، حتی اگر هرگز نمونهای از آن را ندیده باشیم.

- حساسیت به ساختار: ترتیب اجزا حیاتی است. “سگ گاز گرفت مرد” معنایی متفاوت از “مرد گاز گرفت سگ” دارد.

3.2. شکست هوش مصنوعی در ترکیببندی واقعی

هوش مصنوعی فعلی در تقلید این خاصیت اساسی دچار مشکل است. مدلهای مبتنی بر ترانسفورمر (Transformer) در حفظ وابستگیهای دوربرد (Long-range Dependencies) در متن تبحر دارند، اما اغلب در ترکیببندیهای غیرمستقیم یا نوآورانه ضعیف عمل میکنند.

زمانی که AI با یک ترکیب کاملاً جدید روبرو میشود که در دادههای آموزشیاش با فراوانی کافی وجود نداشته است، سیستم معمولاً به “بهترین حدس آماری” خود اکتفا میکند، که اغلب منجر به تولید محتوای متناقض یا فاقد معنای ساختاری عمیق میشود. این امر نشان میدهد که شبکههای عمیق، الگوهای سطحی را میآموزند، اما ساختارهای انتزاعی زیربنایی را نه.

4. تشبیه لگو و معماری ماژولار مغز

برای درک بهتر مزیت رقابتی مغز انسان، میتوانیم آن را به یک جعبه لگوی بینهایت بزرگ تشبیه کنیم، در حالی که هوش مصنوعی اغلب مانند یک قطعه بزرگ پلاستیکی است که به سختی قابل تغییر است.

4.1. لگوهای مغز: واحدهای محاسباتی مستقل

مغز انسان از نظر ساختاری ماژولار است؛ یعنی بخشهای تخصصی (مناطق قشر مغز) برای عملکردهای خاصی تکامل یافتهاند. این مناطق مانند بلوکهای لگو عمل میکنند. هر بلوک (مثلاً ناحیه دیداری V1، ناحیه زبان ورنیکه) وظیفه خاصی دارد و نمادهای اطلاعاتی مشخصی را پردازش میکند.

وقتی ما میخواهیم یک مفهوم جدید خلق کنیم، مغز انسان به جای شروع از صفر، این بلوکهای لگو را برمیدارد و آنها را به روشهای جدیدی به هم متصل میکند.

4.2. معماری شبکههای عصبی: بلوکهای ثابت و وزنهای متغیر

در مقابل، شبکههای عمیق (مانند شبکههای کانولوشنال یا ترانسفورمرها) از وزنهایی تشکیل شدهاند که در طول آموزش، به صورت بسیار گسترده تنظیم میشوند. اگرچه این سیستمها دارای لایههای متعدد هستند، اما این لایهها معمولاً به گونهای سخت سیمکشی شدهاند که به یک هدف خاص برسند.

وقتی AI میخواهد وظیفه جدیدی بیاموزد، باید بخش بزرگی از وزنها را مجدداً تنظیم کند. این تنظیم مجدد، به جای استفاده از دانش موجود به صورت ماژولار، اغلب باعث تخریب دانش قبلی میشود، که ما آن را در بخش بعدی با عنوان “فراموشی فاجعهبار” بررسی خواهیم کرد.

4.3. استفاده مجدد هوشمندانه: اصل صرفهجویی در محاسبات

مغز انسان از اصل صرفهجویی (Parsimony) پیروی میکند. اگر یک الگوی عصبی برای تشخیص لبههای عمودی در تصاویر آموزش دیده باشد، همین الگوی عصبی میتواند برای تشخیص مرزهای پاراگرافها در متن یا حتی مرزهای زمانی در یک توالی موسیقایی استفاده شود. این استفاده مجدد انعطافپذیر از واحدهای محاسباتی مشترک، ستون فقرات یادگیری ترکیبی انسان است.

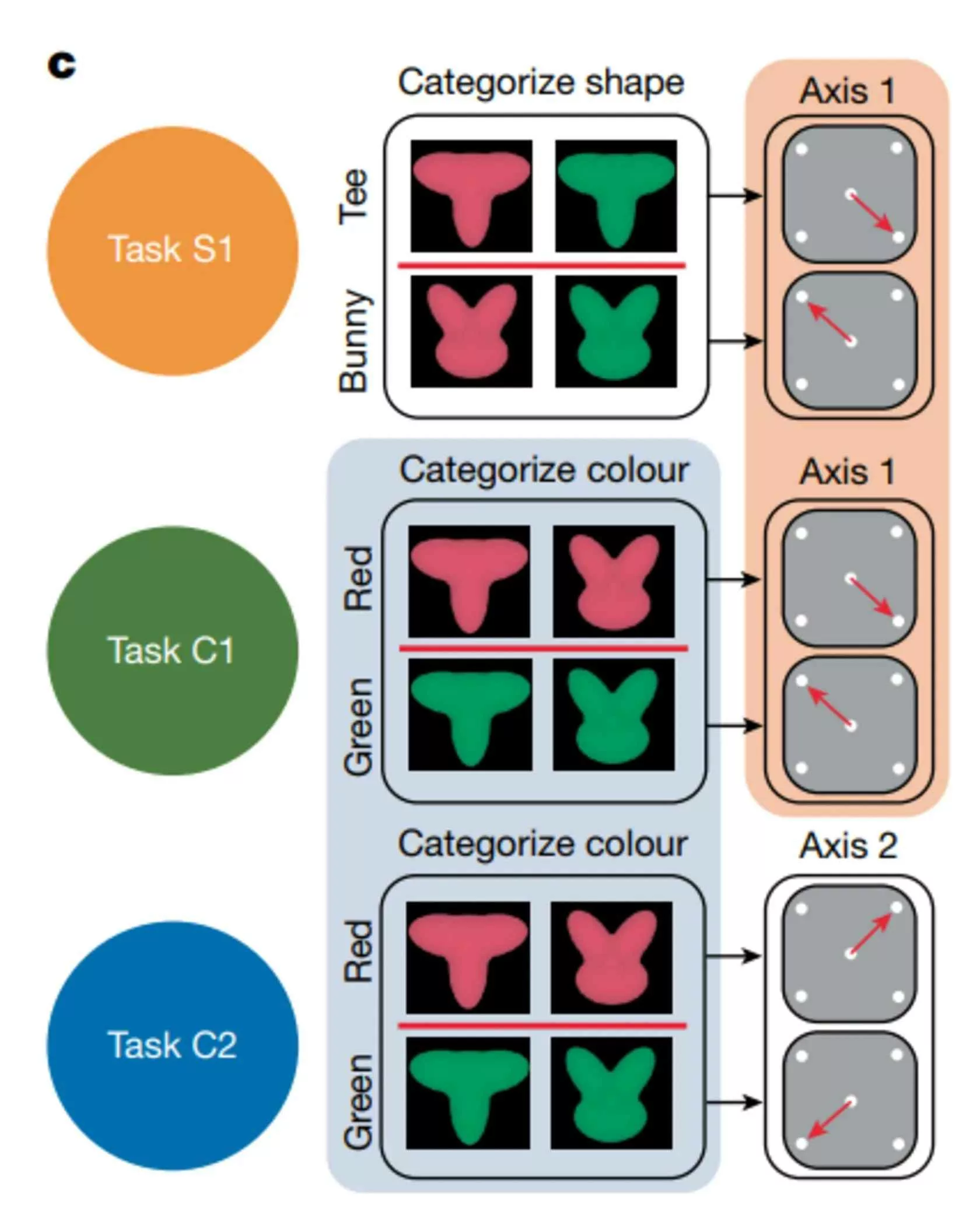

5. مرور پژوهش دانشگاه پرینستون و طراحی آزمایش میمونهای رزوس

برای درک چگونگی تحقق ترکیببندی شناختی در سطح نورونی، باید به شواهد تجربی رجوع کنیم. یکی از تأثیرگذارترین مطالعات در این زمینه، پژوهشی است که توسط تیمهایی در دانشگاه پرینستون و همکارانشان انجام شد، که به بررسی چگونگی یادگیری وظایف ترکیبی در مغز پستانداران (میمونهای رزوس) پرداختند. این پژوهش به دنبال پاسخگویی به این پرسش بود: آیا مغز الگوها را به صورت ماژولار ذخیره میکند تا بتواند آنها را ترکیب کند؟

5.1. هدف پژوهش: رمزگشایی از توانایی ترکیب وظایف

هدف اصلی این پژوهش، مقایسه نحوه کدگذاری اطلاعات در شبکههای عصبی مصنوعی و مغز بیولوژیکی هنگام انجام وظایف نیازمند ترکیببندی بود. پژوهشگران بر این فرض تمرکز کردند که اگر مغز ما از واحدهای محاسباتی استفاده مجدد کند، باید در فعالیتهای عصبی مربوط به وظایف مختلف، همپوشانی یا “فضاهای عصبی مشترک” وجود داشته باشد.

5.2. طراحی آزمایش: میمونها در مقابل الگوریتم

محققان از میمونهای رزوس استفاده کردند که آموزش داده شدند تا دو نوع وظیفه شناختی مجزا را انجام دهند که هر کدام نیازمند تصمیمگیری بر اساس یک محرک بصری خاص بود:

- وظیفه A (حرکت): میمون باید بر اساس جهت حرکت یک نقطه (چپ یا راست) پاسخی حرکتی (مانند فشردن یک دکمه) میداد.

- وظیفه B (رنگ): میمون باید بر اساس رنگ نقطه (قرمز یا آبی) پاسخی متفاوتی میداد.

مهم اینجاست که میمونها سپس برای انجام یک وظیفه ترکیبی آموزش دیدند:

- وظیفه C (ترکیبی): در این حالت، پاسخ میمون هم به جهت حرکت و هم به رنگ وابسته بود. برای مثال، اگر نقطه آبی بود و به سمت چپ میرفت، پاسخ X و اگر قرمز بود و به سمت راست میرفت، پاسخ Y.

این طراحی اجازه میداد تا محققان ببینند آیا نورونهایی که برای وظیفه A کدگذاری شده بودند (حساس به جهت)، برای انجام وظیفه C نیز فعال میشوند یا خیر، و آیا این فعالسازی با آنچه در یک شبکه عصبی مصنوعی رخ میدهد متفاوت است.

6. شرح بازیها، محورها و ثبت فعالیت عصبی

تجربه بر روی میمونهای رزوس مستلزم ثبت دقیق فعالیت الکتریکی نورونها در حین اجرای وظایف بود. این بخش به تشریح جزئیات فنی آزمایش و آنچه ثبت شد، میپردازد.

6.1. ثبت فعالیت عصبی در قشر مغز

الکترودهایی در نواحی مرتبط با تصمیمگیری حرکتی و بینایی (مانند قشر جلوی پیشانی جانبی یا PMFC) میمونها کاشته شد. این الکترودها قادر بودند فعالیت تک تک نورونها (Spike Train) یا فعالیت میانگین نورونها (LFP) را در کسری از ثانیه ثبت کنند.

در طول انجام وظایف A، B و C، محققان فعالیتهای عصبی را در سه سطح تحلیل کردند:

- محور A (جهت): نشاندهنده اطلاعات مربوط به تصمیمگیری حرکتی.

- محور B (رنگ): نشاندهنده اطلاعات مربوط به ویژگی بصری رنگ.

- محور ترکیبی: نشاندهنده خروجی نهایی که ترکیبی از A و B است.

6.2. رویکرد هوش مصنوعی در مقابل رویکرد زیستی

در هوش مصنوعی (مدل پایه): یک شبکه عصبی عمیق که برای انجام وظیفه C آموزش داده شده است، یک لایه نهایی (یا مجموعهای از وزنها) خواهد داشت که مستقیماً اطلاعات کدگذاری شده از ورودی (رنگ و جهت) را برای تولید خروجی ترکیب میکند. این لایه معمولاً ویژگیهای کاملاً جدیدی را میآموزد که فقط در رابطه با ترکیب خاص A و B معنا دارند.

در مغز انسان/میمون: اگر مغز ما از روشهای مشابهی استفاده میکرد، باید میدیدیم که نورونهای جدیدی برای محور ترکیبی C به وجود میآیند که هیچ ارتباطی با نورونهای A و B ندارند.

6.3. نتایج شوکهکننده: حضور فضاهای عصبی مشترک

نتایج این آزمایش نشان داد که مغز انسان و پستانداران، برخلاف انتظار اولیه، از رویکرد “ساختن از نو” پیروی نمیکند. در عوض، شواهد محکمی از وجود “فضاهای محاسباتی مشترک” به دست آمد.

وقتی میمونها وظیفه C (ترکیبی) را انجام میدادند، فعالیت نورونی آنها در درجه اول در همان فضاهایی رخ میداد که برای انجام وظایف مجزای A و B استفاده میشدند. به عبارت دیگر، مغز از همان واحدهای پردازشی که برای کدگذاری جهت و رنگ استفاده میکرد، برای کدگذاری نتیجه ترکیب آنها نیز بهره برد.

7. کشف فضاهای عصبی مشترک و استفاده مجدد از الگوها

کشف اینکه فعالیتهای عصبی مربوط به وظایف مجزا در فضاهای مشترکی قرار دارند، یک کشف کلیدی در درک ترکیببندی شناختی است. این نشان میدهد که مغز فرآیندی دارد که میتواند بدون نیاز به سیمکشی مجدد، اطلاعات را در یک فضای محاسباتی واحد بازآرایی کند.

7.1. تزئین در فضای یادگیری (Task Decoration)

محققان دریافتند که مغز، اطلاعات مربوط به وظایف مختلف را در یک فضای چندبعدی (Latent Space) قرار میدهد. هنگام انجام وظیفه A، نورونها در امتداد یک محور خاص فعال میشوند؛ هنگام انجام وظیفه B، در امتداد محوری دیگر.

هنگامی که وظیفه C (ترکیبی) مطرح شد، به جای ایجاد یک فضای جدید، مغز صرفاً بردارهای مربوط به A و B را در آن فضای مشترک “ترکیب خطی” کرد. این مانند جمع کردن دو بردار در یک صفحه است تا یک بردار جدید حاصل شود.

فرمولبندی ساده شده ترکیب:

[ \text{Activity}_{\text{C}} \approx w_A \cdot \text{Activity}_A + w_B \cdot \text{Activity}_B ]

که در آن ( w_A ) و ( w_B ) وزنهایی هستند که نشاندهنده اهمیت هر وظیفه در ترکیب نهایی هستند، و این وزنها از طریق مکانیسمهای توجه و دستورالعملهای شناختی تنظیم میشوند.

7.2. مزیت اصلی: کارایی و انعطافپذیری

این رویکرد ماژولار و مبتنی بر ترکیب خطی، مزایای عظیمی دارد که هوش مصنوعی کنونی فاقد آن است:

- صرفهجویی انرژی: مغز نیازی به فعالسازی تمام مسیرهای عصبی برای هر وظیفه ندارد. تنها واحدهای لازم برای نمایش مفاهیم پایه فعال و ترکیب میشوند.

- قابلیت ترکیببندی نامحدود: از آنجا که اجزای پایه (مفاهیم پایه) ثابت هستند و تنها نحوه ترکیب آنها تغییر میکند، تعداد بینهایت مفهوم جدید میتواند بدون نیاز به آموزش مجدد گسترده، ایجاد شود. این اساس یادگیری ترکیبی و نوآوری است.

7.3. تفاوت بنیادی با شبکههای عصبی عمیق

در یک شبکه عصبی عمیق استاندارد، حتی اگر وزنهای لایههای اولیه برای استخراج ویژگیهای پایه (مانند لبهها در تصویر) استفاده شوند، ترکیب این ویژگیها در لایههای عمیقتر (مانند لایههای میانی در ترانسفورمرها) اغلب به گونهای رخ میدهد که وزنهای این لایهها برای هر ترکیب خاص “قفل” میشوند. اگر ساختار خروجی تغییر کند، نیاز به تنظیم مجدد کل ساختار است، نه صرفاً تنظیم وزنهای ترکیبکننده.

8. نقش قشر پیشپیشانی در فیلتر و تمرکز شناختی

اگر واحدهای محاسباتی پایه در سراسر مغز برای نمایش مفاهیم مجزا استفاده میشوند، پس چه چیزی باعث میشود مغز انسان در لحظه تصمیمگیری، تنها آن واحدهای مرتبط با وظیفه فعلی را انتخاب کند؟ پاسخ در ناحیهای قرار دارد که اغلب به عنوان “ارکستر دیژیتال” مغز شناخته میشود: قشر پیشپیشانی (Prefrontal Cortex – PFC).

8.1. PFC به عنوان مدیر منابع شناختی

قشر پیشپیشانی مسئول عملکردهای اجرایی سطح بالا است: برنامهریزی، تصمیمگیری، و مهمتر از همه، تنظیم و کنترل توجه. این ناحیه نقش حیاتی در فراهم آوردن زمینه یا “حالت” لازم برای انجام یک کار خاص را ایفا میکند.

در زمینه ترکیببندی شناختی، PFC مانند یک “فیلتر پویا” عمل میکند. هنگامی که ما میخواهیم یک جمله را درک کنیم، PFC تصمیم میگیرد که کدام محورهای اطلاعاتی در فضاهای عصبی مشترک باید برجسته شوند و کدامها باید سرکوب شوند.

8.2. مکانیسم توجه و بازخورد هدایتی

پژوهشها نشان میدهند که PFC از طریق مکانیسمهای “بازخورد هدایتی” (Top-Down Feedback) بر نواحی حسی و حرکتی تأثیر میگذارد. این بازخورد، فعالیت نورونهایی را که به ویژگیهای مرتبط با وظیفه (مثلاً رنگ در مثال ما) کدگذاری شدهاند، تقویت میکند و فعالیت نورونهایی که مربوط به ویژگیهای غیرمرتبط (مثلاً جهت حرکت، اگر وظیفه فقط رنگ باشد) هستند را کاهش میدهد.

قشر پیشپیشانی در واقع، وزنهای ( w_A ) و ( w_B ) در فرمول ترکیب خطی را در زمان واقعی تنظیم میکند تا اطمینان حاصل شود که ترکیب نهایی، دقیقاً همان چیزی است که در محیط مورد نیاز است. این توانایی “تخصیص دینامیک منابع توجه” اساس انعطافپذیری انسان است.

8.3. تفاوت با توجه در AI

در هوش مصنوعی، توجه (Attention Mechanism) در مدلهای ترانسفورمر (مانند آنچه در GPT به کار میرود) یک مفهوم ثابت مبتنی بر ماتریسهای ضرب نقطهای است که اهمیت نسبی ورودیهای مختلف را در تولید خروجی بعدی تعیین میکند. این مکانیسم در سطح شبکهای عمل میکند و اغلب به صورت ذاتی با خود ساختار مدل در هم تنیده است.

اما توجه در مغز انسان، یک لایه مدیریتی است که میتواند تعیین کند کدام ماژولهای محاسباتی (یا کدام محورها در فضای مشترک) فعال یا غیرفعال شوند، و این فرآیند از حوزه قشر پیشپیشانی سرچشمه میگیرد و انعطافپذیری بسیار بیشتری نسبت به ماتریسهای توجه ایستا در AI دارد.

9. دکمه تنظیم صدا در مغز و مدیریت توجه

اگر PFC را “مدیر منابع” بدانیم، باید مکانیزمی وجود داشته باشد که بتواند این منابع را با دقت بالایی تنظیم کند—چیزی شبیه به یک “دکمه تنظیم صدا” (Volume Knob) برای اهمیت یک مفهوم خاص.

9.1. مهار انتخابی (Selective Suppression)

یکی از جنبههای کلیدی ترکیببندی شناختی، توانایی ما در “نادیده گرفتن” اطلاعات نامربوط است. برای مثال، هنگام گوش دادن به یک مکالمه در یک محیط پر سر و صدا (اثر پارادوکسیکال پارتی)، ما به طور فعال سیگنالهای صوتی دیگر را سرکوب میکنیم.

این سرکوب نه تنها حذف اطلاعات، بلکه تنظیم دقیق وزنها است. اگر یک سیگنال بصری (مثلاً رنگ یک توپ) برای تصمیمگیری مهم باشد، نورونهای مرتبط با آن تقویت میشوند. اما اگر در همان لحظه، یک سیگنال حرکتی (مثلاً سرعت توپ) دیگر کمکی به تصمیم نکند، مکانیسمهای بازدارنده (Inhibitory Mechanisms) که توسط PFC هدایت میشوند، سیگنالهای آن نورونها را به شدت کاهش میدهند تا از “آلودگی” فضای ترکیبی جلوگیری شود.

9.2. تمایز بین یادگیری و اجرا

این تفکیک واضح بین یادگیری (تثبیت ساختار فضاهای مشترک) و اجرا (تنظیم وزنهای توجه در زمان واقعی) مزیت دیگری برای مغز انسان فراهم میکند:

- یادگیری (آموزش): مغز ساختار بنیادی ماژولار را میآموزد و نحوه اتصال آنها را تثبیت میکند. این فرآیند آهسته و پرهزینه است (مانند آموزش یک مدل عمیق).

- اجرا (استنتاج): هنگامی که ساختار یاد گرفته شد، تغییر تمرکز بین وظایف یا ترکیب مجدد مفاهیم، سریع و کارآمد (با تنظیم وزنهای توجه) انجام میشود.

هوش مصنوعی مدرن اغلب این دو مرحله را به طور کامل در هم میآمیزد. هر تغییر کوچک در وظیفه، اغلب مستلزم چرخش مجدد در طول مسیر آموزش است که به کندی و هزینه بالا منجر میشود.

10. مقایسه عمیق مغز و شبکههای عصبی مصنوعی

اینجا زمان آن است که تفاوتهای ساختاری میان مدلهای ماژولار مغز و معماریهای فعلی هوش مصنوعی را به صورت مستقیم بررسی کنیم.

ویژگیمغز انسان (هوش بیولوژیکی)شبکههای عصبی مصنوعی (Deep Learning)معماری بنیادیماژولار و سلسلهمراتبی با واحدهای محاسباتی نسبتاً ثابت (نورونها).یکپارچه و کاملاً متصل (Fully Connected) یا ساختارهای کانولوشنی عمیق.ذخیرهسازی دانشدانش در فضاهای عصبی مشترک کدگذاری شده و به صورت خطی ترکیب میشود (Compositionality).دانش به صورت وزنهای توزیع شده در تمام لایهها ذخیره میشود (Distributed Representation).یادگیری چندوظیفهایکارآمد؛ استفاده مجدد از ماژولهای پایه با تغییر وزنهای توجه (PFC).چالشبرانگیز؛ مستعد فراموشی فاجعهبار و تداخل وظیفه.انعطافپذیری و نوآوریبالا؛ توانایی ترکیب مفاهیم آموخته نشده به روشهای جدید.پایین؛ محدود به الگوهای مشاهده شده در دادههای آموزشی.مقیاسبندیکارآمد؛ افزودن یک مفهوم جدید نیاز به آموزش مجدد گسترده ندارد.ناکارآمد؛ افزایش پیچیدگی وظیفه مستلزم افزایش تصاعدی پارامترها و دادهها.

10.1. نمایش توزیعشده در مقابل نمایش ساختارمند

در شبکه عصبی، یک ویژگی واحد (مثلاً تشخیص “لبه عمودی”) میتواند توسط صدها یا هزاران نورون در لایههای مختلف کدگذاری شود، و این کدگذاری برای هر وظیفهای که شبکه انجام میدهد، مجدداً مورد استفاده قرار میگیرد. اما نکته کلیدی این است که نحوه تعامل این نورونها برای هر وظیفه، بخشی از ساختار وزنهای شبکه است.

در مغز انسان، فضای عصبی مشترک، نمایانگر مفاهیم انتزاعی است. ترکیببندی صرفاً یک عملیات ضرب ماتریسی نیست؛ بلکه یک عمل معنایی است که بر روی واحدهای نمادین (حتی اگر این نمادها از نظر فیزیکی توزیع شده باشند) انجام میشود.

10.2. رمزگذاری مجدد در مقابل ترکیب مجدد

AI “رمزگذاری مجدد” (Re-encoding) میکند؛ یعنی برای هر وظیفه جدید، باید وزنها را جوری تنظیم کند که بازنمایی جدیدی از دنیا به دست آید. انسان “ترکیب مجدد” (Re-combining) میکند؛ یعنی اجزای موجود را در یک فرمول جدید قرار میدهد. این همان برتری ترکیببندی شناختی است.

11. مفهوم فراموشی فاجعهبار (Catastrophic Forgetting)

یکی از بزرگترین نقصهای شبکههای عصبی عمیق، که به وضوح نشاندهنده عدم وجود معماری ماژولار انسانگونه است، پدیده فراموشی فاجعهبار (Catastrophic Forgetting) است.

11.1. تعریف و علت ریشهای

فراموشی فاجعهبار به حالتی اطلاق میشود که یک شبکه عصبی، هنگامی که برای یادگیری یک وظیفه جدید (Task 2) آموزش داده میشود، به سرعت و به طور کامل، دانش خود را در مورد یک وظیفه قبلی (Task 1) از دست میدهد.

این پدیده به این دلیل رخ میدهد که الگوریتمهای بهینهسازی (مانند نزول گرادیان) به طور پیشفرض به دنبال یافتن کمترین هزینه (Loss) در مجموعه داده فعلی هستند. وقتی دادههای Task 2 وارد میشوند، پارامترهایی که برای Task 1 حیاتی بودند، به سرعت به سمت مقادیری کشیده میشوند که عملکرد Task 2 را بهینه میکند، در حالی که هیچ مکانیزم داخلی برای محافظت از وزنهای مرتبط با Task 1 وجود ندارد.

11.2. مغز چگونه از این فاجعه جلوگیری میکند؟

مغز انسان به طور ذاتی مقاوم در برابر فراموشی فاجعهبار است. این مقاومت از دو طریق تضمین میشود:

- ماژولار بودن (فضاهای متفاوت یا محافظت شده): همانطور که اشاره شد، نورونهایی که برای یک مفهوم کدگذاری شدهاند، ممکن است در زمینه یک مفهوم جدید تغییر نکنند، زیرا آن مفاهیم در فضای عصبی مجزا (یا با تأکید متفاوت) ذخیره شدهاند.

- اهمیت اتصالات سیناپسی: سیناپسهای مغز پس از یادگیری اولیه، بسیار پایدارتر میشوند. برای “فراموش کردن” یک دانش پایه، نیاز به بازسازی فیزیکی گسترده اتصالات است، نه صرفاً تغییرات جزئی در وزنها. یادگیریهای جدید اغلب از طریق فعالسازی یا تقویت مسیرهای موجود صورت میگیرد، نه جایگزینی آنها.

11.3. راهکارهای AI و ناتوانی در شبیهسازی کامل

تلاشهای زیادی در حوزه یادگیری مداوم (Continual Learning) برای غلبه بر فراموشی فاجعهبار صورت گرفته است، مانند:

- بازپخش تجربی (Experience Replay): تکرار نمونههای قدیمی Task 1 در حین آموزش Task 2 (که از نظر محاسباتی پرهزینه است).

- تثبیت پارامتر (Parameter Regularization): اعمال جریمههای سنگین بر تغییر وزنهایی که در Task 1 مهم بودهاند (مانند EWC – Elastic Weight Consolidation).

این راهکارها نشان میدهند که مهندسان مجبورند به صورت “بیرونی” (با اضافه کردن قوانین و جریمههای دستساز) آنچه مغز انسان به صورت “درونی و ساختاری” انجام میدهد، شبیهسازی کنند. تا زمانی که AI ساختار ماژولار و فضای محاسباتی مشترکی را که قابلیت تفکیک وظایف را بدون تداخل داشته باشد، نداشته باشد، با این مشکل دست و پنجه نرم خواهد کرد.

12. چرا یادگیری عمیق هنوز انسانگونه نیست؟

علیرغم موفقیتهای چشمگیر در دادههای بزرگ (Big Data)، هوش مصنوعی هنوز از “انسانگونه بودن” فاصله دارد. این فاصله به فقدان ساختار ترکیببندی شناختی در هسته خود برمیگردد.

12.1. نیاز به دادههای عظیم در مقابل “یادگیری یکباره”

انسانها برای یادگیری یک مفهوم جدید، اغلب به یک یا چند مثال کافی نیاز دارند (One-shot or Few-shot Learning). یک کودک یک بار پرتاب کردن یک شیء را میبیند و بلافاصله میتواند پیشبینی کند که اگر شیء دیگری را با ویژگیهای مشابه رها کند، چه اتفاقی میافتد.

یادگیری عمیق به هزاران یا میلیونها مثال نیاز دارد. این بدان معنی است که مدلهای AI قادر نیستند از “مفاهیم پایه” استنتاج کنند؛ بلکه باید تمام حالات ممکن ترکیب این مفاهیم را در دادهها مشاهده کنند.

12.2. شباهت محلی در مقابل تعمیم ساختاری

شبکههای عصبی در یافتن “شباهت محلی” عالی هستند. اگر دو تصویر کمی متفاوت باشند، AI میفهمد که هر دو یک گربه هستند. اما آنها در “تعمیم ساختاری” ضعیف هستند.

برای مثال، اگر یک مدل آموزش دیده باشد که “پنجرهها در بالای دیوارها قرار دارند”، و به آن یک تصویر ندهیم که در آن پنجرهها به طور ساختاری جابهجا شده باشند (مثلاً در زیر دیوار)، ممکن است تشخیص ندهد که این یک معماری نامتعارف است و صرفاً فرض کند تصویر خراب است. مغز انسان با استفاده از قوانین فیزیک و منطق (که خود مبتنی بر ترکیببندی است)، میفهمد که اگرچه این ترکیب از نظر مکانی غیرمعمول است، اما هنوز مفهوم “پنجره” و “دیوار” پابرجا است.

12.3. فقدان مدلهای ذهنی درونی

مغز انسان یک “مدل ذهنی” (Mental Model) پویا و درونی از جهان ایجاد میکند. این مدل صرفاً مجموعهای از وزنها نیست، بلکه شبکهای از روابط علت و معلولی است که به ما امکان میدهد جهان را شبیهسازی کنیم.

هوش مصنوعی فاقد این مدلهای درونی است. LLMها روابط آماری بین توکنها را مدلسازی میکنند، نه روابط واقعی فیزیکی یا اجتماعی. این فقدان مدلسازی درونی، مانع اصلی دستیابی به AGI است، زیرا ترکیببندی شناختی مستلزم توانایی دستکاری این مدلهای درونی است.

13. پیامدهای این یافته برای توسعه AGI

نتایج پژوهشهایی مانند مطالعه پرینستون درباره فضاهای عصبی مشترک، مسیر توسعه هوش عمومی مصنوعی (AGI) را روشن میسازد. اگر هدف دستیابی به هوشی شبیه انسان است، باید معماریهای AI را از مدلهای متراکم و توزیعشده به سمت معماریهای ماژولار و ترکیبپذیر سوق دهیم.

13.1. نیاز به معماریهای ماژولار صریح

برای ساخت AGI واقعی، لازم است که مدلها به طور صریح از مکانیزمهای ترکیببندی شناختی تقلید کنند. این به معنای:

- شناسایی واحدهای مفهومی پایه: مدلی باید بتواند مفاهیم اولیه را در واحدهای مستقل خود (شبیه نورونهای مربوط به محور A و B) یاد بگیرد.

- مکانیسم کنترل/توجه قوی (شبیه PFC): سیستمی که بتواند به صورت دینامیک تصمیم بگیرد کدام واحدها را برای انجام یک وظیفه خاص فعال کند و وزنهای بین آنها را تنظیم کند.

این رویکرد، شباهت بیشتری به یادگیری ترکیبی انسان دارد و میتواند به شدت نیاز به دادههای عظیم را کاهش دهد.

13.2. کاهش خطر فراموشی فاجعهبار

با پیادهسازی معماریهای مبتنی بر ماژولهای مستقل که میتوانند در یک فضای مشترک همکاری کنند، میتوان مشکل فراموشی فاجعهبار را به صورت ساختاری حل کرد. اگر یک ماژول کاملاً برای یک مهارت (مثلاً شناختی) آموزش دیده باشد، اضافه کردن یک ماژول جدید برای مهارت دیگر (مثلاً حرکتی) تنها نیاز به تعریف نحوه تعامل آنها دارد، نه بازنویسی کامل هر دو ماژول.

13.3. دستیابی به استدلال انتزاعی پیشرفته

ترکیببندی، زبان استدلال است. وقتی انسانها استدلال میکنند، در واقع در حال ترکیب مفاهیم هستند. AGI تنها زمانی قادر خواهد بود استدلالهای پیچیده و چندمرحلهای انجام دهد که بتواند نمادها را به صورت معنایی (نه صرفاً آماری) ترکیب کند. این امر نیازمند سیستمی است که قابلیت بازنمایی ساختاریافته مفاهیم را داشته باشد.

14. هوش مصنوعی ماژولار؛ آیندهای الهامگرفته از مغز

حرکت به سوی هوش مصنوعی ماژولار، نه یک انتخاب، بلکه یک ضرورت برای پیشرفت فراتر از LLMهای فعلی است. این مدلها، که اغلب به عنوان مدلهای یکپارچه (Monolithic) شناخته میشوند، به نقطه اشباع بازدهی خود نزدیک شدهاند.

14.1. پارادایم شبکههای متخصصان (Mixture of Experts – MoE)

یکی از اولین گامها در این مسیر، استفاده گستردهتر از معماریهایی مانند Mixture of Experts (MoE) است که به طور طبیعی بر ایده ماژولار بودن تکیه دارد. در MoE، ورودیها توسط یک شبکه “مسیریاب” (Gater Network) به یکی از چندین “متخصص” (Expert Network) هدایت میشوند.

این مفهوم بسیار شبیه به فضاهای عصبی مشترک است؛ مسیریاب نقش قشر پیشپیشانی را ایفا میکند که تعیین میکند کدام متخصص (ماژول) باید برای پردازش دادهها فعال شود. با این حال، متخصصان MoE هنوز به طور کامل از نظر عملکردی از هم جدا نیستند و مانند مغز از قابلیت استفاده مجدد کامل بهره نمیبرند.

14.2. سیستمهای نمادین-نمادین (Symbolic-Neural Hybrids)

آینده AGI احتمالاً در ادغام تواناییهای شبکههای عصبی (پردازش شهودی و یادگیری از داده) با قدرت استدلال سیستمهای نمادین سنتی (که ساختارهای منطقی و ترکیببندی را به صورت صریح نمایش میدهند) نهفته است.

در این سیستمهای ترکیبی، شبکههای عصبی وظیفه استخراج ویژگیها و تبدیل آنها به “نمادهای معنایی” را بر عهده میگیرند. سپس، یک موتور استدلال نمادین، این نمادها را با استفاده از قوانین ترکیببندی شناختی دستکاری میکند تا پاسخهای پیچیده و قابل توجیه ارائه دهد. این همان چیزی است که مغز انسان به طور ذاتی انجام میدهد: تبدیل ادراک حسی به نمادهای ذهنی و ترکیب آنها.

14.3. یادگیری افزایشی و تدریجی

معماریهای آینده باید از یادگیری افزایشی (Incremental Learning) پشتیبانی کنند، جایی که هر دانش جدید به جای جایگزینی، به مجموعه دانش موجود اضافه میشود. این امر مستلزم این است که ماژولهای دانش پس از یادگیری اولیه، “محافظت” شوند تا در برابر فراموشی فاجعهبار مقاوم باشند.

15. کاربردها: رباتها، خودروهای خودران، دستیارهای هوشمند

مزیتهای ناشی از ترکیببندی شناختی و معماری ماژولار، تنها تئوریهای آکادمیک نیستند؛ بلکه مستقیماً بر کاربردهای عملی هوش مصنوعی تأثیر میگذارند.

15.1. رباتیک و کار در محیطهای ناشناخته

رباتهایی که بر اساس شبکههای عمیق آموزش دیدهاند، اغلب در محیطهایی که کمی با محیط آموزش متفاوت است، شکست میخورند. برای مثال، رباتی که یاد گرفته است یک شیء را در یک میز بردارد، اگر شیء کمی کج باشد یا رنگ میز تغییر کند، ممکن است از کار بیفتد.

رباتهای ماژولار الهامگرفته از مغز میتوانند از ترکیببندی شناختی استفاده کنند: آنها مفهوم “دستکاری” (Grasping) و مفهوم “شیء” و مفهوم “سطح” را به صورت ماژولار ذخیره میکنند. اگر رنگ سطح تغییر کند، ماژول “سطح” دچار تغییر نمیشود، بلکه تنها ماژول “تشخیص رنگ” نیاز به تنظیم دارد و این ماژولها به صورت ترکیبی برای انجام وظیفه جدید ترکیب میشوند. این امر باعث میشود رباتها در محیطهای پویا و غیرقابل پیشبینی، بسیار کارآمدتر عمل کنند.

15.2. خودروهای خودران و پیشبینی موقعیتهای لبهای (Edge Cases)

بزرگترین چالش در خودروهای خودران، مدیریت “موقعیتهای لبهای” است—شرایط نادری که در دادههای آموزشی پوشش داده نشدهاند (مثلاً یک گاو در حال عبور از بزرگراه در مه غلیظ).

هوش مصنوعی فعلی برای پیشبینی این موقعیتها متکی بر شباهتهای آماری است. اما مغز انسان میتواند با ترکیب قوانین فیزیکی (“اگر جسمی سنگین باشد، توقف زمان بیشتری میبرد”) و دانش محیطی (“گاوها بزرگ هستند”)، پاسخی ایمن را ترکیب کند. دستیابی به این سطح از استدلال نیازمند ساختار یادگیری ترکیبی در خود معماری AI است.

15.3. دستیارهای هوشمند شخصیسازی شده

دستیارهای هوشمند میتوانند درک کنند که یک کاربر، “اولویتهای کاری” متفاوتی نسبت به “اولویتهای خانوادگی” دارد. در یک سیستم ماژولار، ما میتوانیم یک ماژول برای مدیریت زمانبندی کاری و یک ماژول دیگر برای یادآوریهای خانوادگی داشته باشیم. قشر پیشپیشانی شبیهسازی شده در این دستیار، میتواند به سرعت بین این دو حالت جابجا شود و بدون اینکه ماژول خانوادگی دچار فراموشی فاجعهبار شود، اولویتهای کاری را اجرا کند.

16. محدودیتهای پژوهش و چالشهای پیشرو

اگرچه پژوهشهای مربوط به فضاهای عصبی مشترک امید زیادی برای ساخت AGI ایجاد کردهاند، اما مسیر پیش رو چالشهای بزرگی دارد که نباید نادیده گرفته شوند.

16.1. ابهام در نقش دقیق نورونها

یکی از بزرگترین محدودیتها این است که درک ما از نحوه کدگذاری مفاهیم در مغز انسان هنوز کامل نیست. در آزمایش میمونهای رزوس، ما توانستیم نحوه ترکیب دو وظیفه ساده را مشاهده کنیم. اما ترکیببندی شناختی انسان شامل ترکیب هزاران مفهوم انتزاعی در سطوح مختلف است. نمیتوانیم تضمین کنیم که تمام این ترکیبها به سادگی ترکیب خطی در یک فضای مشترک رخ میدهند.

16.2. پیچیدگی سختافزاری مورد نیاز

اگر بخواهیم ساختار ماژولار مغز را به صورت کامپیوتری شبیهسازی کنیم، ممکن است نیاز به سختافزاری داشته باشیم که قابلیت اتصال تعداد بسیار زیادی واحد محاسباتی با قابلیت فعالسازی و سرکوب دینامیک (شبیه عملکرد سیناپسی) را داشته باشد. این معماریها از نظر محاسباتی میتوانند بسیار پرهزینه باشند، مگر اینکه بتوانیم به روشهای کارآمدی برای یافتن فضاهای عصبی مشترک دست یابیم.

16.3. مدلسازی PFC و کنترل بالا به پایین

شبیهسازی عملکرد قشر پیشپیشانی و کنترل هدایتی آن، بزرگترین مانع در حال حاضر است. مکانیسمهای دقیق عصبی که تعیین میکنند کدام ماژول فعال شود (انتخاب وزن ( w_A ) و ( w_B ))، هنوز به طور کامل رمزگشایی نشدهاند. این کنترل سطح بالا نیازمند یک حلقه بازخورد شناختی است که در حال حاضر فاقد آن هستیم.

17. جمعبندی نهایی با نگاه آیندهپژوهانه

رقابت میان مغز انسان و هوش مصنوعی در حال حاضر، نبردی بر سر تعریف “هوش” است. هوش مصنوعی در بهینهسازی الگوریتمها و شناسایی الگوهای حجیم بینظیر است، اما در انعطافپذیری ساختاری و نوآوری محدود است. برگ برنده مغز انسان در توانایی بنیادین آن برای ترکیببندی شناختی نهفته است.

تحقیقات دانشگاه پرینستون به روشنی نشان داد که این مزیت ناشی از استفاده هوشمندانه از فضاهای عصبی مشترک است، جایی که واحدهای محاسباتی پایه به صورت ماژولار نگهداری و توسط مکانیسمهای کنترلی (PFC) ترکیب میشوند. این ساختار، مقاومتی ذاتی در برابر فراموشی فاجعهبار ایجاد میکند و امکان یادگیری ترکیبی سریع و کارآمد را فراهم میسازد.

آینده AGI در گروی تقلید این معماری ماژولار است. ما باید از مدلهای یکپارچه به سمت سیستمهایی حرکت کنیم که:

- دانش را در واحدهای مستقل (ماژولها) کدگذاری کنند.

- این واحدها را در یک فضای مشترک برای ترکیبپذیری قرار دهند.

- یک لایه کنترلی قوی برای مدیریت توجه و انتخاب وزنهای ترکیب داشته باشند.

وقتی هوش مصنوعی بتواند مانند مغز، بلوکهای لگوی دانش خود را به این شیوه انعطافپذیر ترکیب کند، آنگاه میتوانیم ادعا کنیم که به هوشی دست یافتهایم که واقعاً شبیه انسان است، هوشی که نه تنها میداند، بلکه میداند چگونه آنچه را میداند، به روشهای کاملاً جدید به کار برد.

18. بخش پرسشهای متداول (FAQ)

1. ترکیببندی شناختی (Compositionality) دقیقاً به چه معناست؟

پاسخ: ترکیببندی شناختی اصلی است که بیان میکند معنای یک عبارت پیچیده تابعی است از معنای اجزای سازنده آن و نحوه ترکیب آنها. این توانایی به ما اجازه میدهد مفاهیم جدیدی را با ترکیب اجزای شناخته شده بسازیم، حتی اگر هرگز نمونهای از آن ترکیب را ندیده باشیم.

2. مغز انسان چگونه با AI در ترکیببندی تفاوت دارد؟

پاسخ: مغز از معماری ماژولار استفاده میکند و مفاهیم پایه را در فضاهای عصبی مشترک ذخیره میکند. هنگامی که نیاز به ترکیب است، صرفاً وزنهای این فضاهای مشترک را تنظیم میکند (ترکیب خطی). AI معمولاً ویژگیهای جدیدی را در لایههای عمیقتر میآموزد که به صورت سخت به وظایف خاصی قفل شدهاند، و در نتیجه انعطافپذیری کمتری در ترکیب دارد.

3. فراموشی فاجعهبار چیست و چرا برای AI یک مشکل است؟

پاسخ: فراموشی فاجعهبار زمانی رخ میدهد که یک مدل شبکه عصبی برای یادگیری وظیفه جدید، به سرعت دانش قبلی خود را از دست میدهد. این مشکل به دلیل عدم وجود تفکیک واضح بین دانش (ماژولها) در معماریهای متراکم AI رخ میدهد.

4. پژوهش دانشگاه پرینستون چه چیزی را ثابت کرد؟

پاسخ: این پژوهش شواهد نوروفیزیولوژیکی قوی ارائه داد که در میمونهای رزوس، وظایف ترکیبی (مانند تصمیمگیری بر اساس رنگ و جهت) از همان زیرساختهای عصبی (محورهای فعالیت) که برای وظایف مجزا استفاده میشد، بهره میبرد. این امر نشاندهنده استفاده از فضاهای عصبی مشترک است.

5. آیا AGI نیازمند ترکیببندی شناختی است؟

پاسخ: بله، به احتمال زیاد. هوش عمومی مصنوعی (AGI) باید بتواند استدلالهای نوآورانه انجام دهد و از دانش قبلی برای حل مسائل کاملاً جدید استفاده کند. این قابلیتها مستلزم توانایی ترکیببندی نمادین و انتزاعی است که مغز از طریق ترکیببندی به دست میآورد.

6. نقش قشر پیشپیشانی (PFC) در این فرآیند چیست؟

پاسخ: PFC به عنوان یک “مدیر منابع شناختی” عمل میکند. این ناحیه از طریق بازخورد هدایتی، تعیین میکند که کدام ماژولها یا محورهای اطلاعاتی در فضای عصبی مشترک باید برای انجام وظیفه فعلی تقویت یا سرکوب شوند. این نقش تنظیم وزنهای توجه را بر عهده دارد.

7. چگونه میتوان از فراموشی فاجعهبار در هوش مصنوعی جلوگیری کرد؟

پاسخ: یکی از راههای الهام گرفته از مغز، حرکت به سوی هوش مصنوعی ماژولار است. با ساخت سیستمهایی که در آنها دانش در ماژولهای مجزا ذخیره شده و تنها نحوه تعامل آنها تنظیم میشود (مانند مدلهای MoE)، میتوان از تداخل پارامترها جلوگیری کرد.

8. آیا LLMهای فعلی (مانند GPT) ترکیبپذیر هستند؟

پاسخ: LLMها در سطح نحوی و متنی بسیار ترکیبپذیر به نظر میرسند، اما این ترکیب اغلب آماری است. آنها در ترکیببندیهای ساختاری که نیازمند درک روابط علت و معلولی یا منطقی عمیق هستند، دچار محدودیت میشوند و به ندرت میتوانند فراتر از الگوهای دادههای آموزشی خود نوآوری کنند.

9. شباهت بین معماری مغز و مدلهای Mixture of Experts (MoE) چیست؟

پاسخ: هر دو سیستم از ایده “تخصیص” استفاده میکنند. در MoE، یک شبکه مسیریاب، ورودی را به یک متخصص مناسب هدایت میکند. در مغز، PFC تصمیم میگیرد که کدام مجموعه از نورونهای تخصصی (ماژولها) باید برای حل مسئله فعال شوند.

10. چرا یادگیری عمیق نیازمند دادههای بسیار بیشتری نسبت به انسان است؟

پاسخ: زیرا یادگیری عمیق از ابتدا کل ساختار پارامتری را برای هر وظیفه “یاد میگیرد” و آن را در وزنها تثبیت میکند. انسانها با استفاده از ترکیببندی شناختی، دانش پایه را میآموزند و سپس آن را به سرعت ترکیب میکنند، در نتیجه به دادههای کمتری برای یادگیری یک مفهوم جدید نیاز دارند.

11. یادگیری ترکیبی (Compositional Learning) چه تفاوتی با یادگیری چندوظیفهای (Multi-Task Learning) دارد؟

پاسخ: یادگیری چندوظیفهای شامل آموزش همزمان چند وظیفه است که غالباً منجر به تداخل منفی میشود. یادگیری ترکیبی بر توانایی استفاده مجدد از اجزای آموخته شده (ماژولها) برای ساخت مفاهیم جدید تأکید دارد و هدف آن تعمیمپذیری است، نه صرفاً عملکرد همزمان.

12. آیا روشهای منظمسازی (Regularization) میتوانند مشکل فراموشی فاجعهبار را حل کنند؟

پاسخ: روشهای منظمسازی مانند EWC به عنوان راهحلهای کمکی عمل میکنند؛ آنها سعی میکنند با جریمه کردن تغییرات، نقش “محافظ” را بازی کنند. با این حال، این روشها مکانیسم ساختاری محافظت از دانش را که در مغز وجود دارد، ارائه نمیدهند و اغلب عملکرد را در کل سیستم محدود میکنند.

13. آینده AGI بیشتر به کدام سمت متمایل است: شبکههای بزرگ یا معماریهای ماژولار؟

پاسخ: پژوهشها نشان میدهند که برای رسیدن به هوش واقعی که قادر به استدلال و تعمیم در محیطهای ناآشنا باشد، آینده به سمت هوش مصنوعی ماژولار و هیبریدی (ترکیب نورونی و نمادین) متمایل است که از مزایای ترکیببندی شناختی بهره میبرد.

14. چگونه میتوانیم استفاده مجدد از الگوها در مغز را مدلسازی کنیم؟

پاسخ: از طریق مدلسازی صریح فضاهای عصبی مشترک. این کار شامل طراحی معماریهایی است که در آنها لایههای اولیه ویژگیهای پایه را استخراج میکنند و سپس لایههای کنترلی (مشابه PFC) میتوانند بردار این ویژگیها را در فضای مشترک به صورت خطی ترکیب کنند تا خروجیهای پیچیدهتر تولید شود.

15. آیا مغز انسان هرگز دانش خود را فراموش نمیکند؟

پاسخ: مغز نیز فراموش میکند، اما این فراموشی معمولاً فرآیندی تدریجی و مرتبط با عدم استفاده یا تغییرات سیناپسی آهسته است. این با فراموشی فاجعهبار که در AI آنی و مرتبط با آموزش یک وظیفه جدید است، تفاوت فاحشی دارد.